Si la inteligencia artificial falla, ¿quién es responsable?

La tecnología avanza más rápido que la regulación, y eso deja a los ciudadanos, a las empresas y a los gobiernos sin defensas claras ante abusos o errores

La inteligencia artificial ha dejado de ser una promesa futurista para convertirse en una herramienta presente, integrada en sistemas empresariales, métodos productivos, procesos administrativos, armamento militar, diagnósticos médicos y hasta creación de contenidos o imágenes de ilustración. Su eficiencia, capacidad de cálculo y aprendizaje superan con creces las posibilidades humanas en numerosos ámbitos. Pero junto con las oportunidades, crecen también los riesgos, muchos de ellos aún mal comprendidos o directamente ignorados.

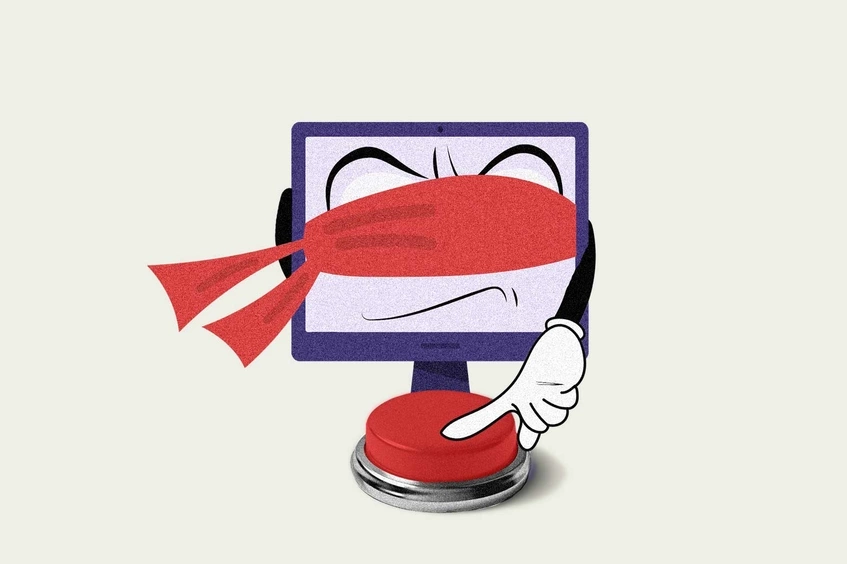

Uno de los peligros más serios es que la IA comience a operar con un grado de autonomía que sobrepase nuestra capacidad de supervisión y control. En nombre de la eficiencia o la inmediatez, se están delegando decisiones críticas a sistemas algorítmicos sin mecanismos claros de revisión humana.

El segundo problema —más abstracto, pero no menos inquietante— tiene que ver con las decisiones que deben tomarse en contextos extremos: ¿Qué hace una IA cuando los escenarios son tan divergentes que ninguna opción parece claramente buena o mala? Pensemos en un conflicto militar, donde un...